tokenembedding,tokenembedding的作用

HAF是专为层次文本分类任务打造的模型,它的核心在于LabelEmbedding和Attention机制的巧妙运用这个框架由一系列单元组成,每层对应于标签层次结构中的一级,信息从上层逐层传递,通过A

HAF是专为层次文本分类任务打造的模型,它的核心在于Label Embedding和Attention机制的巧妙运用这个框架由一系列单元组成,每层对应于标签层次结构中的一级,信息从上层逐层传递,通过Attention机制,将当前层的Label Embedding与token特征紧密融合,进行精准预测HAF的设计旨在解决标签嵌入生成注意力机制设计。

2接下来把所有的词汇输入BERT,然后每个输入的token都会得到一个embedding 3接下来将设置为ltMASK的embedding输入到Linear Multiclass Classifier中中,要求它预测被ltMASK的词汇是哪个词汇? 但是这个Linear Multiclass Classifier它仅仅是一个线性分类器,所以它的能力十分弱,这也就需要在之前的BERT模型中需要将它。

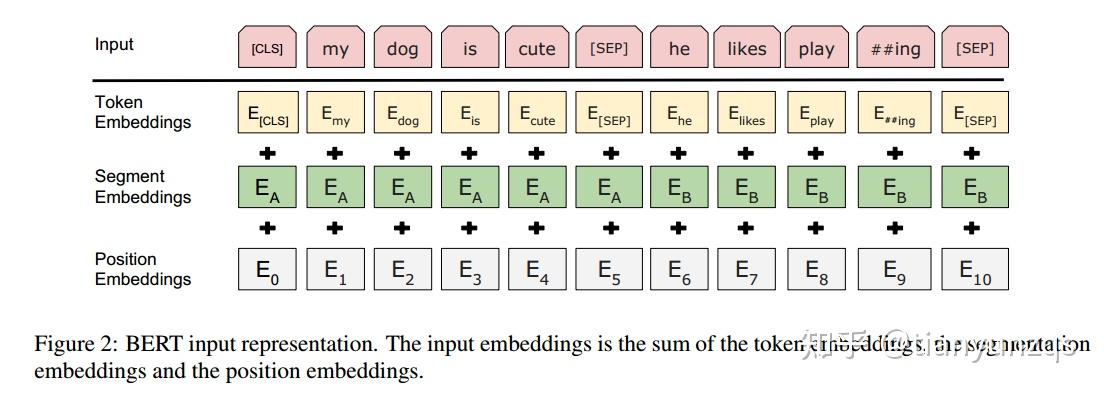

引入Position Embedding主要是为了弥补Transformer模型对位置信息的不足,将Position Embedding与token Embedding相加后,即可保留各个token的位置信息论文作者提出了两种添加位置信息的的方法 一种方法是直接用不同频率的正余弦函数直接计算各个token的位置id,公式如下另一种方法是直接学习出一个Position。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~