nlptoken的简单介绍

NLP模型,包括NLP应用AppZoo预训练模型ModelZoo数据仓库DataHub等特性由于跨模态理解和生成需求的不断增加。

NLP 模型,包括NLP应用 AppZoo 预训练模型 ModelZoo数据仓库DataHub等特性由于跨模态理解和生成需求的不断增加。

BPEByte pair encoding算法是NLP中常见的tokenizer方式,关于其介绍和实现原理,读者可参考深入理解NLP Subword算法。

NLP最火的网红 Transformer 和 BERT 就是Subword的带盐人,来看个它们做tokenization的栗子,I have a new GPU 'i', '。

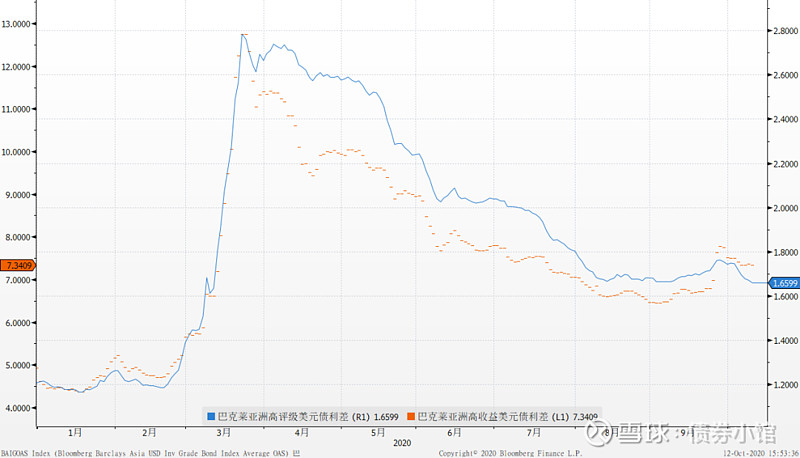

而不管这些token与语言建模任务的相关性如何,如下图所示研究人员将这些占用了大量注意力的初始token称为注意力池。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~