tokenizationnlp的简单介绍

tokenization errors的负面影响,而且更具有表达性和嵌入输入句子的灵活性 NMT特点 传统的统计机器翻译模拟管道pipeline中源语言和目标语言之间的潜在结构和对应关系, NMT则是训练了一个统一的编码解码神经网络,其中编码器将输入的句子映射成固定长度的向量,解码器从编码的向量生成翻译基于词格的递归神经网络 NMT。

答 多头注意力层和激活函数层之间CV使用BN是认为channel维度的信息对cv方面有重要意义,如果对channel维度也归一化会造成不同通道信息一定的损失而同理nlp领域认为句子长度不一致,并且各个batch的信息没什么关系,因此只考虑句子内信息的归一化,也就是LN答 批归一化是对每一批的数据在进入。

面对NLP中的词表挑战,子词分词方法如Subword Tokenization显得尤为重要其中,Byte Pair EncodingBPE是解决OOVOutofVocabulary和减少词典规模的有效工具BPE通过逐步合并最常见的字符对,生成有限的子词表,既能保证词汇的覆盖面,又控制了词表的复杂性BPE的具体步骤包括收集大量文本数据。

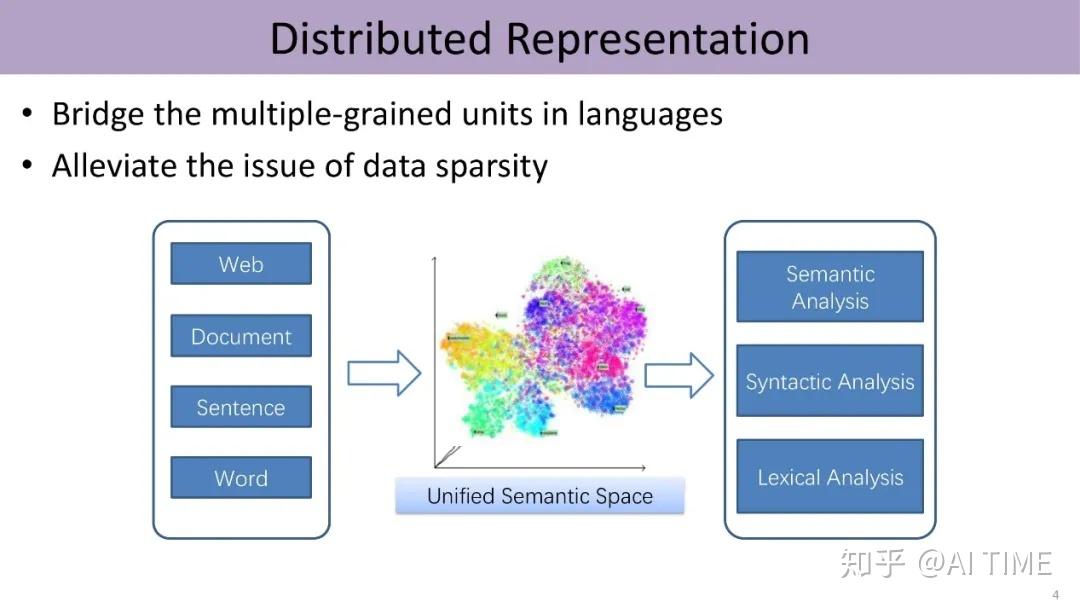

AI识别提问问题的方式通常依赖于自然语言处理NLP技术,该技术结合了计算机科学人工智能和语言学的原理AI系统会通过以下步骤来理解和识别问题1 分词Tokenization将输入的文本分割成单词短语或其他有意义的单元,称为“tokens”2 词性标注PartofSpeech Tagging确定每个token的词性如。

BytePairEncoding是用于解决未登录词的一种方法首先简单提一句什么是未登录词,未登录词可以理解为训练语料库中没有出现的,但是在测试语料库中出现的词我们在处理NLP任务时,通常会根据语料生成一个词典,把语料中词频大于某个阈值的词放入词典中,而低于该阈值的词统统编码成quot#UNKquot这种处理方法。

自然语言处理技术有标记化删除停止词提取主干单词嵌入词频逆文档频率主题建模情感分析1标记化Tokenization标记化指的是将文本切分为句子或单词,在此过程中,我们也会丢弃标点符号及多余的符号这个步骤并非看起来那么简单举个例子纽约New York一词被拆成了两个标记,但纽约。

于是赶紧回顾了下18年之后NLP的发展,基本就是将迁移学习更广泛的用于NLP领域,以及把17年年底的Attention is all you need里的思想给发扬光大了,ELMO弥补了传统word2vec多义词表示的不足,GPT使用更强大的特征提取器Transformer取代LSTM,Bert使用双向Transformer进一步改进了GPT成为这两年发展的集大成者 从Bert模型。

全书包括了分词tokenization词性标注POS语块Chunk标注句法剖析与语义剖析等方面,是nlp中不错的一本实用教程 当然缺点还是有的算是鸡蛋挑骨头吧首先对理论介绍不够,这可能与本书实用性很强的写作风格有关,如果你要想了解更多的理论,可以看专门讲理论的书籍其次对中文。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~